私有化GPT分析文档 -- LocalGPT

本文最后更新于:2023年12月30日 凌晨

今天主要是通过localGPT这个开源框架,使用我家闲置的Mac Mini使用LLAMA-CPP模型,私有化部署并分析本地文档。

准备环境

1. 克隆项目

1 | |

2. 安装conda来做虚拟环境管理

1 | |

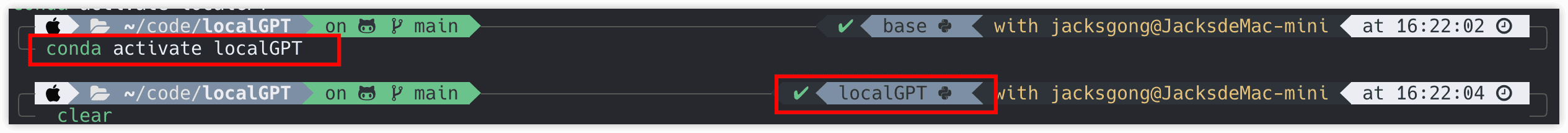

4. 启动localGPT的虚拟环境

1 | |

5. 安装依赖

1 | |

6. 安装LLAMA-CPP:

比如我是Mac Mini(M2芯片)

1 | |

至此已经安装完成。

配置与运行

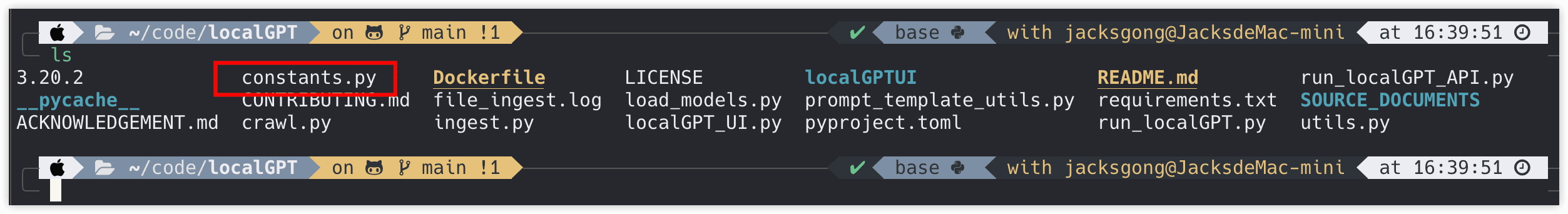

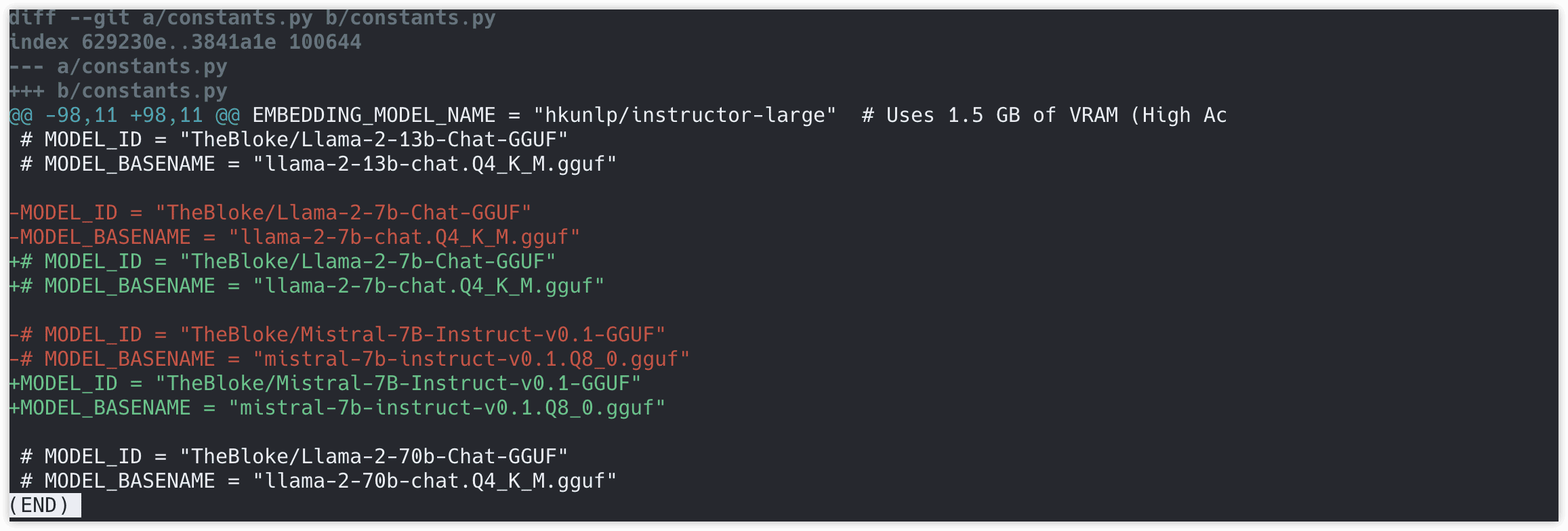

1. 选择模型

如果你希望修改想要的模型,就可以打开constants.py文件:

比如我换了一个模型:

2. 提取数据

通过执行,以下代码来提取默认的SOURCE_DOCUMENA目录下的所有文件内容:

1 | |

你可以将你想要提取的文件放在该目录下,然后重新提取。

3. 下载模型并且在命令行中执行

1 | |

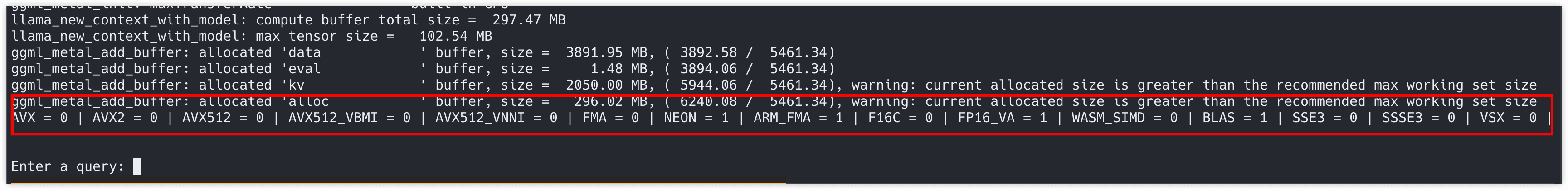

执行后就可以在Terminal中直接询问了:

私有化GPT分析文档 -- LocalGPT

https://blog.dreamtobe.cn/local_gpt_deploy/